亚马逊的Alexa到底神奇在哪里(2)

|

所以Amazon选择了稳妥的从音箱品类进行升级,当然苹果也选择了从耳机进行升级。这就特别要注意,传统品类升级的时候一定要避免与其他品类的冲突,比如假设给Echo加上屏幕,用户会把这个品类看成音箱还是平板?我想Amazon更愿意用户把Echo看作为音箱,即便他们非常不情愿。 事实上,国内很多创业公司都在验证Amazon的眼光有多么独到,因为我们已经看到太多配置屏幕的机器人和智能音箱,甚至还有不少耳机产品。其销量为什么不好?为什么不换个角度想想,这种场景下,用户买个iPad Mini是不是会是更好的选择? 4当前阶段用户真的需要多轮对话? Toni Reid的观点很明确,Alexa暂时不需要多轮对话,因为这会让早期用户的体验更糟糕。笔者也坚持这个观点,但是有几点是必须补充的。 首先来看,现在的语音交互实际上都是语音控制,确实这个阶段我们真的很难让计算机理解人类语言。在这个前提下,真正的多轮对话实际上很难做到,当前更多的是解决基于场景的搜索问题。当不能真正理解用户思想的时候,多出的对话若不能解决用户的需求,反而是用户极其反感的地方。简单想想,真正使用一个产品的时候,面对着冷冰冰的机器,难道让用户和机器沟通要比和女朋友沟通还要费劲吗?抱歉,即便作为用户,笔者也只是想要一个绝对听从于我指令的音箱而已,声智科技经常会测试各个厂商的Demo,但凡偶尔唤不醒或者一句没听懂我就挺恼火的。 其次来看,我们怎么理解多轮对话?Toni Reid提到不希望Alexa问到第三遍,这实际上还不是一个多轮对话的问题,而是问答反馈的问题。也就是说,真正的多轮对话可能不需要,但是问答反馈还是必须得,我们知道Echo由于没有了屏幕,先天丢失了用户交互过程中的反馈途径,这个时候语音的反馈就显得比较重要。但是这是一个很大的坑,到底该如何把握这种问答反馈,既让用户快速获取满意的答案,又能在模糊的时候通过一次问答来解决用户问题,我想这个方面真的需要仔细研究Echo,Echo的成功就是仔细思考和打磨了每个细节。 事实上,可以连续唤醒的单轮问答对话才是智能音箱的核心技术所在,简单可以理解为智能音箱的唤醒是第一优先级的,必须支持连续的无数次唤醒,做到有问必答,也就是说用户可以随时唤醒并且打断其他对话直接唤醒,而且必须保障唤醒率和虚警率,虚警率太高显然不行,这会让设备总是莫名其妙自动对话。当然,声智科技的这项技术当前还主要针对大客户定制,开发板暂时还不支持这项功能。 5深度学习真解决了语音交互问题? 这个问题实在不好解释了,引用微软首席研究员刘铁岩的一句话,顺便也推荐感兴趣的同学看看刘研究院所做的《人工智能的挑战与机遇》演讲,这给国内火热的人工智能泼了一盆冷水,但是我相信所有从事这个行业的技术人士都是有清晰认识的。 “所谓深度学习实验室,就是一批会调参的人,没有他们深度学习就没那么好用。虽然是句玩笑,但是深度学习要调的东西确实太多了,比如说训练数据怎么来,怎么选,如果是分布式运算怎么划分,神经网络结构怎么设计,10层、100层还是1000层,各层之间如何连接,模型更新的规则是什么,学习率怎么设,如果是分布式运算各个机器运算出来的结果怎么聚合,怎么得到统一的模型,等等,太多需要调的东西,一个地方调不好,结果可能就大相径庭。这就是为什么很多论文里的结果是不能重现的,不是说论文一定不对,但至少人家没有把怎么调参告诉你,他只告诉了你模型长什么样而已。” 那么,从上面几个问题继续引申,我们到底应该怎么看待持续火热的Alexa和Echo?国内公司该是怎样理解和思考人工智能,笔者拙见,也提几点个人的看法和建议,期望AI能在理性的环境中成长。AI是未来的趋势,创业者长期的事业,绝对不是一蹴而就的事情。 1 AI最大的问题是不懂人脑机制 上面也提到了深度学习的问题,我们大量的工作其实就是工程师所做的事情,不断调参优化,这是一个持续优化的过程,最终结果不可能是颠覆性的。因此,不能指望理论上所不能证明的事情,通过调优就能实现。 所以AI最大的问题还是会归结于最原始的哲学问题,人类的智慧是怎么来的? AI根本不懂人脑的机制,怎么超越人脑?这点就从笔者最熟悉的声学来看,这个领域为啥大家都不爱进入,甚至本科都不开设这个专业?甚至声智科技成立以前,很多大众媒体同学都不知道还有个中科院声学所。 因为声学100多年没有啥实质性理论突破了,虽然在水声领域我们国际上也很领先,但是和深度学习类似,我们也是在做大量实验和调优的工作,这就很难产生颠覆性的贡献。这么久没有理论上的突破必然会导致公众的遗忘,甚至再过百年都看不到诺贝奖的希望,谁还来搞呢?毕竟学子年轻的时候都充满了希望,但是怎么做到呢? 2 语音识别的最大瓶颈在于声学 前面提到,语音识别最大的落地还是在场景之中,这涉及了语音交互用户场景的变化,当用户从手机切换到类似Echo智能音箱或者机器人的时候,实际上麦克风面临的环境就完全变了,这就如同两个人窃窃私语和大声嘶喊的区别。 前几年,语音交互应用最为普遍的就是以Siri为代表的智能手机,这个场景一般都是采用单麦克风系统。单麦克风系统可以在低噪声、无混响、距离声源很近的情况下获得符合语音识别需求的声音信号。但是,若声源距离麦克风距离较远,并且真实环境存在大量的噪声、多径反射和混响,导致拾取信号的质量下降,这会严重影响语音识别率。而且,单麦克风接收的信号,是由多个声源和环境噪声叠加的,很难实现各个声源的分离。这样就无法实现声源定位和分离,这很重要,因为还有一类声音的叠加并非噪声,但是在语音识别中也要抑制,就是人声的干扰,语音识别显然不能同时识别两个以上的声音。 显然,当语音交互的场景过渡到以Echo、机器人或者汽车为主要场景的时候,单麦克风的局限就凸显出来。为了解决单麦克风的这些局限性,利用麦克风阵列进行语音处理的方法应时而生。麦克风阵列由一组按一定几何结构(常用线形、环形)摆放的麦克风组成,对采集的不同空间方向的声音信号进行空时处理,实现噪声抑制、混响去除、人声干扰抑制、声源测向、声源跟踪、阵列增益等功能,进而提高语音信号处理质量,以提高真实环境下的语音识别率。 但是仅靠麦克风阵列提供的这些技术还是不够的,这只能解决部分远场化的问题。事实上,真实场景下我们需要更复杂的识别技术,能不能不依赖于云端?能不能同时追踪和识别多个人讲话?能不能识别语调和情感?等等这些环节,都是急需要解决的问题?而很多技术的瓶颈就在于声学能否也有一个较大的突破。 3 语音助手核心在于场景和性格 (编辑:ASP站长网) |

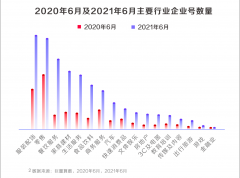

《2021抖音私域经营白

《2021抖音私域经营白 副业刚需 一文带你全

副业刚需 一文带你全 小红书如何自建鱼塘获

小红书如何自建鱼塘获 物联网产品设计中Wi-F

物联网产品设计中Wi-F